Reporte: Conferencia Latinoamericana de Inteligencia Artificial y Protección de Datos

El 1 de octubre se llevó a cabo la I Conferencia Latinoamericana de Inteligencia Artificial y Protección de Datos. En dos sesiones, la Conferencia abordó temas clave en torno a la implementación de un sistema de inteligencia artificial en la región, como la aplicación de la privacidad desde el diseño, la experimentación a través de sandboxes regulatorios y la creación de prototipos de políticas, y la búsqueda de un equilibrio entre la innovación y la protección de datos. A continuación, describimos, a partir de los discursos de los ponentes y sus comentarios posteriores, algunos aspectos destacados del webinar (la grabación completa se puede encontrar aquí).

Sesión 1

Jackline Conca

Subsecretaria de Innovación y Transformación Digital, Ministerio de Economía de Brasil

La Sra. Subsecretaria Jackline Conca destacó que la Inteligencia Artificial (IA) es actualmente un tema crítico, especialmente dadas sus potenciales ramificaciones beneficiosas o dañinas. Los sistemas de inteligencia artificial ya están integrados en los procesos de toma de decisiones de varios sectores y existen riesgos, pero también existen oportunidades económicas, sociales y ambientales.

Brasil se adhirió a la declaración de la OCDE, referente de principios y valores para el desarrollo de la IA. Luego creó la Estrategia Brasileña de Inteligencia Artificial, actualmente administrada por una estructura de gobierno compuesta por más de 30 entidades que trabajan para implementar acciones concretas, como la elaboración de principios éticos, la promoción de la inversión en infraestructura de investigación y desarrollo, capacitación y formación de profesionales etc. Además, recientemente, la Cámara aprobó el proyecto de ley relacionado con la IA en Brasil.

En este contexto, la señora Conca destacó la importancia de pensar en el rol del poder público. Regular las tecnologías emergentes es difícil: es necesario equilibrar la innovación y los derechos, la ética y la seguridad. IA aún tiene mucho que desarrollar y, en su opinión, la regulación, si es extensa, podría terminar perjudicando su desarrollo en el país. Todavía no conocemos satisfactoriamente los impactos positivos y negativos de la IA, por lo que una regulación excesiva puede llevar a una reducción de la innovación. Ante esto, la regulación debe basarse en principios y privilegiar la autorregulación sectorial.

La Sra. Subsecretaria luego se centró en aspectos del proyecto de ley relacionado con la IA que actualmente se debate en el Congreso brasileño. Entre los principios determinados por el proyecto se encuentran salvaguardas como el respeto a los derechos fundamentales, la no discriminación, la transparencia y la implementación de medidas de mitigación de riesgos. Este último punto comunica con el concepto de regulación basada en riesgos, tal como se introdujo en la propuesta de regulación de la IA en la Unión Europea. Sin embargo, contrariamente a la propuesta europea, el PL brasileño no define campos tecnológicos que están prohibidos debido al alto riesgo (en Europa, habría algunas prohibiciones y obligaciones ex ante más severas para algunos usos específicos de la IA – ver artículo 5). Esto estaría en consonancia con la visión de una regulación proporcional al riesgo evaluado caso por caso.

La idea, entonces, sería privilegiar la intervención solo cuando sea absolutamente necesaria, considerando el riesgo y el contexto de cada sistema de IA. La regulación sectorial es similar a lo que ocurre en EE.UU., donde la FDA tiene la prerrogativa de regular y aprobar algoritmos aplicados en salud.

La Subsecretaría de Innovación ha estado trabajando en estrecha colaboración con el Centro para la 4ª Revolución Industrial asociado al Foro Económico Mundial, en São Paulo, en la realización de proyectos piloto para comprender formas de mitigar los riesgos de las aplicaciones de IA. Un piloto cuya implementación comenzará en breve implica el uso de IA para monitorear las estaciones del metro de São Paulo, con miras a comprender los riesgos involucrados y las formas de mitigarlos.

En cuanto a la protección de datos personales, la LGPD (la ley brasileña de protección de datos) ya ha fomentado una postura “impulsada por los datos” y ya actúa para mitigar varios de los riesgos relacionados con las aplicaciones de IA, lo que sería otro elemento de equilibrio en la regulación de la IA. Existe una disposición del derecho a revisar decisiones automatizadas, la capacidad de ANPD para auditar y un requisito de informe de impacto, además del concepto de privacidad por diseño, todos elementos de la LGPD que ya protegen al titular contra las aplicaciones de IA.

Ana Brian

Relatora Especial de la ONU sobre Privacidad

La Sra. Relatora Especial argumentó que estamos en un momento de gran desarrollo tecnológico, especialmente basado en el uso de datos, particularmente en aplicaciones de IA. Hace unos años, se habló mucho sobre el “fin de la privacidad”: había aplicaciones de tecnología en todas partes en las que se recopilaban y procesaban datos personales.

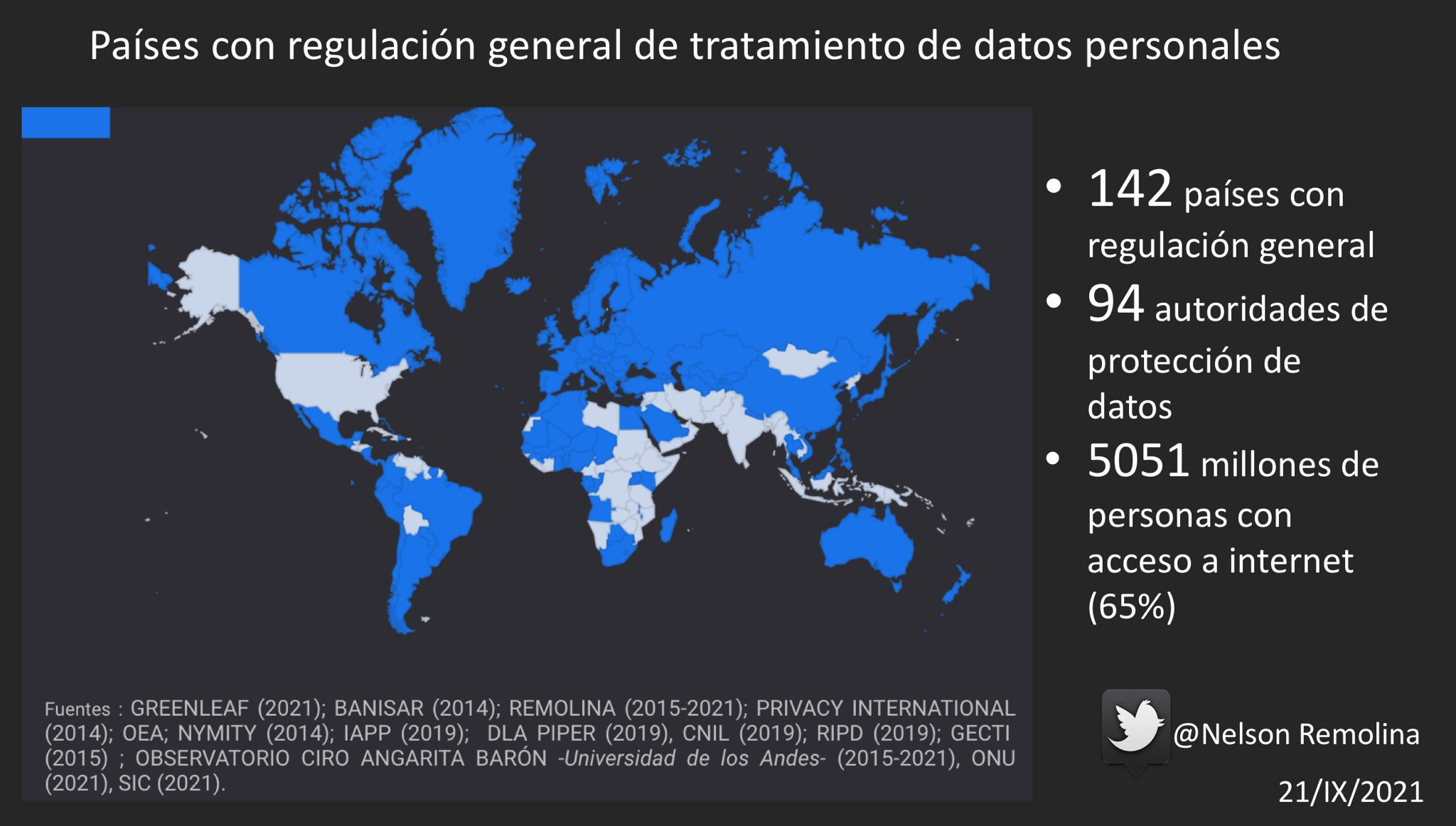

Sin embargo, hoy en día el panorama es diferente: la protección de datos personales muestra una clara evolución, con 142 países que cuentan con algún tipo de regulación para la protección de datos personales. El RGPD europeo es una de estas normativas, y representa una postura más estricta en relación a la protección de datos personales que las tendencias observadas hasta su creación.

La regulación de la IA que se debate actualmente en Europa se basa en una clasificación que diferencia las aplicaciones de estos sistemas. Esta clasificación se basa en el daño potencial a los usuarios, con aplicaciones que son inaceptables y sistemas considerados de alto riesgo para los derechos de los ciudadanos (relacionados con el transporte, la salud, la biometría, la educación y educación profesional, la seguridad, el empleo, los servicios, la aplicación de la ley, migración, administración de justicia o procesos democráticos), riesgo limitado (que requiere obligaciones específicas transparencia) y riesgo mínimo (como filtros de spam). Las aplicaciones incluidas en juguetes para niños, por ejemplo, ocupan una categoría fuertemente regulada, mientras que los chatbots ocupan una categoría menos regulada, con las correspondientes obligaciones según el grado de riesgo.

En cuanto al reconocimiento facial, la tendencia de esta normativa europea es limitar su uso para la vigilancia y control de lugares públicos. También en este punto, Michelle Bachelet, Alta Comisionada de las Naciones Unidas para los Derechos Humanos, emitió un comunicado en el que proponía una moratoria sobre la comercialización y el uso de sistemas de inteligencia artificial que presentan riesgos para los derechos humanos hasta que se implementen las salvaguardas necesarias.

En desarrollos recientes en la región, cabe destacar que Uruguay adoptó, en 2019, una estrategia de IA para la gobernanza electrónica; y que Colombia está implementando una estrategia de sandbox regulatorio para probar implementaciones de inteligencia artificial basadas en la privacidad por diseño. Esta parece ser una herramienta interesante para probar posibles implementaciones y obtener información relevante.

Una última reflexión planteada por la Relatora Especial se refiere al significado y la esencia de la inteligencia artificial: “Si la inteligencia artificial pretende emular la inteligencia humana, y si la empatía y la moralidad son aspectos que permean la inteligencia humana, ¿por qué deberíamos olvidarlos cuando se trata de inteligencia artificial?”.

Farzana Dudhwala

Gerente de Política de Privacidad, Políticas y Gobernanza de IA, Facebook

La IA presenta nuevos desafíos para la regulación, que pueden tomar muchas formas. Es importante permitir que las nuevas tecnologías se desarrollen y prosperen. Los sandboxes regulatorios pueden ser herramientas interesantes, ya que permiten probar iniciativas en escenarios controlados. Otra opción es la gobernanza experimental y, en particular, la elaboración de prototipos de políticas públicas, que son medios de colaboración multisectorial para comprender los desafíos regulatorios de un área.

Si bien los sandboxes se utilizan a menudo para reformar las regulaciones existentes bajo la supervisión de un organismo regulador, la creación de prototipos de políticas sirve para crear nuevas regulaciones cuando no existen. Por tanto, la creación de prototipos es menos formalista y aporta mayor flexibilidad para pensar en medios de regulación que se adapten a la realidad de las nuevas tecnologías.

La creación de prototipos de políticas se ha aplicado en el proyecto Open Loop, que busca crear un ciclo positivo entre los reguladores y los implementadores de este reglamento. En América Latina, el proyecto se ha centrado en la transparencia, la explicabilidad, el análisis de riesgos y la equidad de la IA. El ciclo tiene fases alfa, de investigación y de prueba, y fases beta de iteración y ajuste. Concretamente, esto se traduce en cuatro pasos:

- un consorcio de actores de múltiples orígenes y perfiles desarrollan un texto básico sobre un tema, por ejemplo, la explicabilidad de los sistemas de IA;

- este prototipo es probado y aplicado en escenarios reales, bajo observación para identificar los puntos donde debe ajustarse para lograr una mayor eficiencia;

- las lecciones aprendidas se comparten entre todos los actores para que se desarrollen nuevas iteraciones regulatorias;

- y finalmente, las experiencias de todos los actores involucrados se cotejan en un documento final de recomendación de política pública.

El proyecto se aplicó en México con un enfoque de transparencia y explicabilidad durante un período de seis meses. Se puso gran énfasis en la creación de alianzas entre los diversos actores involucrados, con el aporte de expertos de la región. El informe final del proyecto se está ultimando actualmente y se publicará en breve.

Karen Duque

Gerente de Asuntos Gubernamentales y Políticas Públicas de Google

Los usos de la IA tienen un gran potencial beneficioso, pero también implican graves riesgos. Sin embargo, la inteligencia artificial y la privacidad no se cancelan entre sí, o al menos no es necesario que lo hagan. Un ejemplo interno de Google es el desarrollo de Google Assistant.

Cada proyecto que se desarrolla en la empresa se basa en tres principios: seguridad de la información, manejo responsable y siempre poner al usuario en control. Esto se traduce, en el Asistente de Google, en una serie de opciones, capacidades y elecciones de diseño para los asistentes.

Esto incluye el hecho de que, por defecto, el dispositivo no guarda grabaciones de audio; la capacidad de borrar todos los datos con solo un comando de voz; ajustar los plazos de borrado automático de datos; especificar la sensibilidad del asistente al comando de voz; y el modo invitado, que prohíbe el acceso a datos personales sin impedir el uso del dispositivo. Un último ejemplo son los principios de desarrollo de inteligencia artificial de Google, que incluyen la privacidad desde el diseño, la seguridad y la responsabilidad.

Veridiana Alimonti

Analista sénior de políticas de EFF

La innovación tecnológica y los derechos de los usuarios deben ir de la mano. La LGPD proporciona algunos principios importantes, como la transparencia, la necesidad y la buena fe, y es un hito importante para la participación social y la garantía de derechos. El proyecto de ley sobre la IA debería aspirar a ser el mismo, pero está marcado por debates legislativos apresurados y un enfoque regulatorio superficial.

El uso de tecnologías de IA por parte de los gobiernos debe basarse en la comprensión de la protección de datos como un derecho fundamental. En Brasil, esto es una consecuencia del caso reciente que involucra al IBGE, decidido por el STF, pero puede ser aún más concreto con la aprobación de la propuesta de enmienda a la constitución n. 17/2019. Por lo tanto, la adopción de tecnologías que pueden afectar la protección de datos debe pasar una prueba de equilibrio de derechos.

La LGPD brinda una serie de garantías, plasmadas en los derechos de los interesados, que se aplicarán a las implementaciones de IA. El derecho a revisar las decisiones automatizadas debe verse desde el punto de vista del debido proceso, de modo que el titular no solo pueda solicitar la revisión, sino también comprenderla. En este punto, es importante señalar que incluso las decisiones que no están completamente automatizadas, pero que contienen algún paso de automatización, también deben garantizar el acceso a la información que sustente las decisiones. La observación de los principios de protección de datos personales, en este sentido, permite un mejor equilibrio de decisiones y debe servir de base para la implementación de políticas públicas relacionadas con los sistemas de IA.

Nina da Hora

Investigadora de CTS-FGV, Miembra del Consejo de Seguridad de TikTok Brasil

La visión técnica y la mirada del usuario deben superponerse y conectarse. La seguridad digital implica necesariamente comprender cómo se relacionará el usuario con una nueva tecnología. Los asistentes personales, por ejemplo, han ayudado a las personas con discapacidad de formas impredecibles. Diseñar herramientas de inteligencia artificial significa comprender las habilidades de los usuarios para comprenderlas y usarlas.

La tecnología seguirá estando cada vez más presente e ineludible. Pensar en la regulación de la IA implica lidiar con tecnologías y no simplemente rechazarlas o vetarlas. Es importante que la sociedad civil se acerque al proceso regulatorio para crear normas que aborden de manera efectiva los desafíos de la tecnología. También es importante acercar la industria y la academia para brindar educación sobre el uso de tecnologías. Además es crucial formar personas capaces no solo de construir tecnología, sino también de pensar en ella: encontrar los riesgos antes de que se conviertan en problemas reales.

Sesión 2

Alejandro Pisanty

Miembro de la Alianza Global de la OCDE para la IA

El desarrollo de la tecnología y la regulación en América Latina es muy desigual. El algoritmo presenta varios niveles de sesgo, algunos comparables a los sesgos que surgen en la acción humana misma, otros más severos.

América Latina cuenta con un rico ecosistema de jóvenes creativos profundamente involucrados en el desarrollo de herramientas tecnológicas, y es necesario incentivar el desarrollo ético de este ecosistema. El GPAI reúne a expertos de diversos orígenes en torno al desarrollo responsable de la IA.

Algunos aspectos destacados de los proyectos desarrollados en GPAI son (i) la creación de una entidad de intermediación para el consentimiento para el uso de datos para IA; y (ii) la aplicación de la IA para el descubrimiento de nuevos fármacos. En cuanto a la regulación, es importante reconocer que existe un discurso refractario a la regulación y guiado por la autorregulación, y es importante que se utilicen mecanismos multisectoriales para establecer regulaciones que no sean ni demasiado severas ni demasiado permisivas.

Fabrizio Scrollini

Director de ILDA

ILDA buscó recopilar lo que se sabe sobre las políticas y prácticas de IA en América Latina. En general, se puede decir que la región está mal preparada. Un desafío profundo que enfrentan incluso los proyectos desarrollados en América Latina es el uso de bases de datos generadas en otras regiones, referidas a otras poblaciones, lo que genera grandes discrepancias y defectos en la aplicación final de la IA. Un caso particularmente relevante es el de una calculadora de riesgo de enfermedades crónicas. Al ajustar los datos a la realidad de la población relevante (mexicana, en este caso), se mejoró enormemente la efectividad de la herramienta.

Se pueden ver algunos desafíos y conocimientos comunes en la región. En primer lugar, existe una amplia variedad de estrategias de IA en América Latina, pero esto a menudo no se refleja necesariamente en las inversiones necesarias y, a menudo, se traduce en documentos no específicos, que se caracterizarían más apropiadamente como cartas de intención en lugar de estrategias: las estrategias e inversiones están muy por debajo de lo que deberían ser, con pocas excepciones, en América Latina. En segundo lugar, hay poca claridad con respecto a la gobernanza de datos. En tercer lugar, existe una gran desigualdad en relación a la implementación de las estrategias, presentando algunos países enfoques específicos diferentes a los definidos en las estrategias. Y cuarto, esa regulación no es tanto un impedimento en relación con los datos públicos como en relación con los datos privados; en este caso, puede haber barreras de desarrollo reales.

Sacha Alanoca

Investigadora sénior de políticas públicas para IA en The Future Society

Es interesante analizar el uso de la IA para combatir la pandemia, ya que esta revela muchas de las oportunidades y desafíos de esta tecnología en relación a la protección de datos, así como algunos puntos sobre las políticas públicas de IA. En un análisis de más de 100 herramientas de IA aplicadas para combatir la IA, se identificaron tres categorías de aplicaciones: a nivel molecular (identificación y comprensión del virus); en el campo clínico (mejorando y acelerando el diagnóstico); y en el campo social (infodemiología, epidemiología y toma de decisiones basada en evidencia).

Algunas dificultades compartidas encontradas fueron barreras éticas y legales (utilizando datos sensibles, principalmente); acceso a datos confiables; y adopción y confianza públicas. Este último punto es de especial importancia, especialmente en un contexto de crisis sanitaria. Para generar confianza, es importante que las decisiones se tomen a través de procesos participativos; que los planes de implementación se desarrollen con responsabilidades claras; y que se haga un esfuerzo activo para identificar los riesgos potenciales de las aplicaciones de IA.

Arturo Muente-Kunigami

Especialista senior del Banco Interamericano de Desarrollo

Es importante encontrar un equilibrio entre los intereses involucrados en el desarrollo de la IA. Es necesario encontrar espacios de coordinación entre industria, gobierno y sociedad civil. En este esfuerzo, la intención debe ser ante todo comprender y conocer la IA y sus riesgos, incluida la reflexión sobre posibles medidas de mitigación; y la necesidad de concienciar e informar a la población sobre los usos de los datos personales.

En general, las personas comprenden que la protección de datos es importante, pero no saben exactamente por qué. Es posible que la idea de los fideicomisos de datos promueva un mayor control ciudadano, pero esto debe ir de la mano de estos esfuerzos de información y concientización para que surta efecto. Un destaque en el BID es la iniciativa fAIr LAC, enfocada en promover el uso responsable y ético de los datos en el desarrollo de la IA. La idea no es frenar la innovación, sino promover la conciencia de los riesgos involucrados.

Otra importante línea de atención es la creación de normativas específicas en materia de IA en la región. Incluso las aplicaciones de inteligencia artificial que no involucran datos personales, en cuyo caso las leyes de protección de datos personales no se aplicarían, pueden tener efectos críticos en la vida de las personas, por lo que una regulación equilibrada es esencial. Un punto crucial es la aplicación de algoritmos en los procesos del sector público, dado el impacto y los riesgos involucrados, lo que plantea la pregunta de si el sector público debe trabajar exclusivamente con algoritmos abiertos para promover la transparencia.

Constanza Gómez Mont

Fundadora y Presidente de C Minds; AI Chair for Humanity, Chair for World Economic Forum Global Futures Council on AI for Humanity

¿Cómo superar el desafío de la confianza en las herramientas de IA? ¿Cómo implementar la explicabilidad y eliminar los sesgos? Estos son temas de importancia crítica frente a una creciente digitalización y adopción de la IA, incluso por parte de las pequeñas empresas. El tema, al final, es determinar el acceso a los derechos: servicios, productos y la realización de la igualdad.

Existe un gran desafío en el sur global, donde solo un número limitado de personas y empresas son conscientes de la importancia de la gobernanza de la IA, su impacto en sus vidas y derechos fundamentales, así como de la comprensión de las buenas prácticas de IA. Las pequeñas empresas, en particular, a menudo dependen del desarrollo de terceros sin comprender cómo se construyen estas herramientas y qué protecciones existen. Comprender la complejidad de los desafíos de la IA debe ser una preocupación transversal en estas empresas, no restringida a áreas técnicas, y con la participación real de los más altos niveles de gestión.

En general, las empresas europeas ya están mejor adaptadas a la preocupación por los desafíos de la IA en sus aplicaciones debido a una relación de larga data con las regulaciones ya vigentes. En Latinoamérica, sin embargo, muchas empresas priorizan otras inversiones e inquietudes debido principalmente, como hemos aprendido en varios proyectos que lideramos, a la falta de conciencia sobre el tema, los recursos económicos y humanos.

Sin embargo, es necesario que tanto los consumidores como las empresas sean conscientes de que los desafíos de la IA en las aplicaciones tecnológicas tienen efectos reales en la vida de las personas y también en el rendimiento del mercado: en términos de eficiencia, pues los sistemas de IA bien construidos se adaptan mejor al objetivo y la audiencia y por lo tanto son más eficientes; en términos de ganancias o pérdidas de reputación, ya que la construcción de sistemas éticos de IA puede marcar la diferencia entre ellos; y, lo que es igualmente importante, en términos del impacto en la vida de sus partes interesadas y comunidades más amplias, ya que la IA puede tener un impacto negativo si no se centra en los derechos humanos y la ética.

En definitiva, es necesario generar espacios de discusión multisectorial abierta y participativa para promover cambios significativos. Algunos puntos particularmente importantes que deben abordarse son los sesgos de la IA, sus impactos en el medio ambiente y la promoción de la transparencia y la explicabilidad de las aplicaciones de IA. Las iniciativas en curso en América Latina que abordan estos temas son, por ejemplo, el Eon Resilience Lab, el fAIr LAC liderado por el BID y las recomendaciones de la UNESCO y la OCDE para una IA ética, entre otras. Además, el proyecto Open Loop Mexico, el primer prototipo de política en la región en cuanto a probar los mecanismos de gobernanza para la transparencia y la explicabilidad de la IA, liderado por Facebook, C Minds, en colaboración con el Banco Interamericano de Desarrollo y el apoyo del Instituto Nacional. de Transparencia, Acceso a la Información y Protección de Datos Personales (INAI), con participación de empresas y un grupo de expertos, son proyectos experimentales de gobernanza que dan como resultado lecciones fundamentales para la regulación en este campo.