Relatório: Conferência Latino-americana de Inteligência Artificial e Proteção de Dados

Em 01 de outubro, ocorreu a 1a Conferência Latino-Americana de Inteligência Artificial e Proteção de Dados. Em duas sessões, a Conferência cobriu questões-chave em torno da implementação de sistema de inteligência artificial na região, como a aplicação do privacy by design, a experimentação por meio de sandboxes regulatórios e prototipagem de políticas e a busca por equilíbrio entre inovação e proteção de dados pessoais. Descrevemos a seguir, a partir das falas dos palestrantes e seus comentários posteriores, alguns destaques do webinar (a gravação completa pode ser encontrada aqui).

Sessão 1

Jackline Conca

Subsecretária de Inovação e Transformação Digital, Ministério da Economia do Brasil

A Sra. Subsecretária Jackline Conca destacou que a Inteligência Artificial (IA) é atualmente um tema crucial, especialmente dados suas potenciais ramificações benéficas ou prejudiciais. Os sistemas de IA já estão inseridos nos processos de tomada de decisão de vários setores e há riscos, mas há também oportunidades de ganhos econômicos, sociais e ambientais que compensam.

O Brasil aderiu à declaração da OCDE, uma referência de princípios e valores para o desenvolvimento da IA. Criou, em seguida, a Estratégia Brasileira de Inteligência Artificial, gerida atualmente por uma estrutura de governança composta por mais de 30 entidades que trabalham para implementar ações concretas, como a elaboração de princípios éticos, a promoção do investimento em infraestrutura de pesquisa e desenvolvimento, capacitação e formação de profissionais etc. Além disso, recentemente, o projeto de lei relativo à IA no Brasil foi aprovado na Câmara.

Neste contexto, a Sra. Conca destacou a importância de se pensar o papel do poder público. Regular tecnologias emergentes é difícil: é preciso equilibrar inovação e direitos, ética e segurança. A IA tem muito a se desenvolver, ainda, e, em sua visão, a regulação, se extensiva, pode acabar prejudicando o seu desenvolvimento no país. Ainda não conhecemos satisfatoriamente os impactos positivos e negativos da IA, de modo que a regulação desmedida pode levar ao estrangulamento da inovação. Diante disto, a regulamentação deveria ser principiológica e privilegiar a autorregulação setorial.

A Sra. Subsercretária então concentrou-se em aspectos do PL relativo à IA atualmente em discussão no Congresso. Dentre os princípios determinados pelo projeto estão salvaguardas como o respeito aos direitos fundamentais, a não discriminação, a transparência e a implantação de medidas de mitigação de riscos. Este último ponto se comunica com o conceito de regulação baseada em risco, como introduzido na proposta de regulação de IA na União Europeia. Ao contrário, no entanto, da proposta europeia, o PL brasileiro não define campos tecnológicos vedados devido ao alto risco (na Europa, haveria algumas proibições e obrigações mais severas ex-ante para alguns usos específicos da IA – ver artigo 5º). Isto seria alinhado à visão de uma regulação proporcional ao risco aferido caso a caso.

A ideia, então, seria privilegiar a intervenção apenas quando absolutamente necessário, considerando o risco e o contexto de cada sistema de IA. A regulação setorial se assemelha a o que ocorre nos EUA, onde o FDA tem a prerrogativa de regular e aprovar algoritmos de aplicação na saúde.

A Subsecretaria de Inovação tem trabalhado de perto com o Centro para a 4ª Revolução Industrial associado ao Fórum Econômico Mundial, em São Paulo, na realização de projetos pilotos para compreender formas de mitigar os riscos de aplicações de IA. Um piloto cuja implementação se iniciará em breve envolve o uso de IA para o monitoramento das estações do metrô de São Paulo, com vistas a compreender os riscos envolvidos e as formas de mitigá-los.

Com relação à proteção de dados pessoais, a LGPD já tem incentivado uma postura “data-driven” e já atua na mitigação de vários dos riscos relativos às aplicações de IA, o que seria mais um elemento balanceador na regulação de IA. Há previsão de direito de revisão de decisões automatizadas, capacidade de auditoria pela ANPD e requerimento de realização de relatório de impacto, além do conceito de privacy by design, todos elementos da LGPD que já protegem o titular em face a aplicações de IA.

Ana Brian

Relatora Especial da ONU para Privacidade

A Sra. Relatora Especial argumentou que estamos em um momento de grande desenvolvimento tecnológico, especialmente baseado no uso de dados – em particular nas aplicações de IA. Há alguns anos, muito se falava sobre o “fim da privacidade” – por todos os lados se via aplicações de tecnologia em que se coletavam e tratavam dados pessoais.

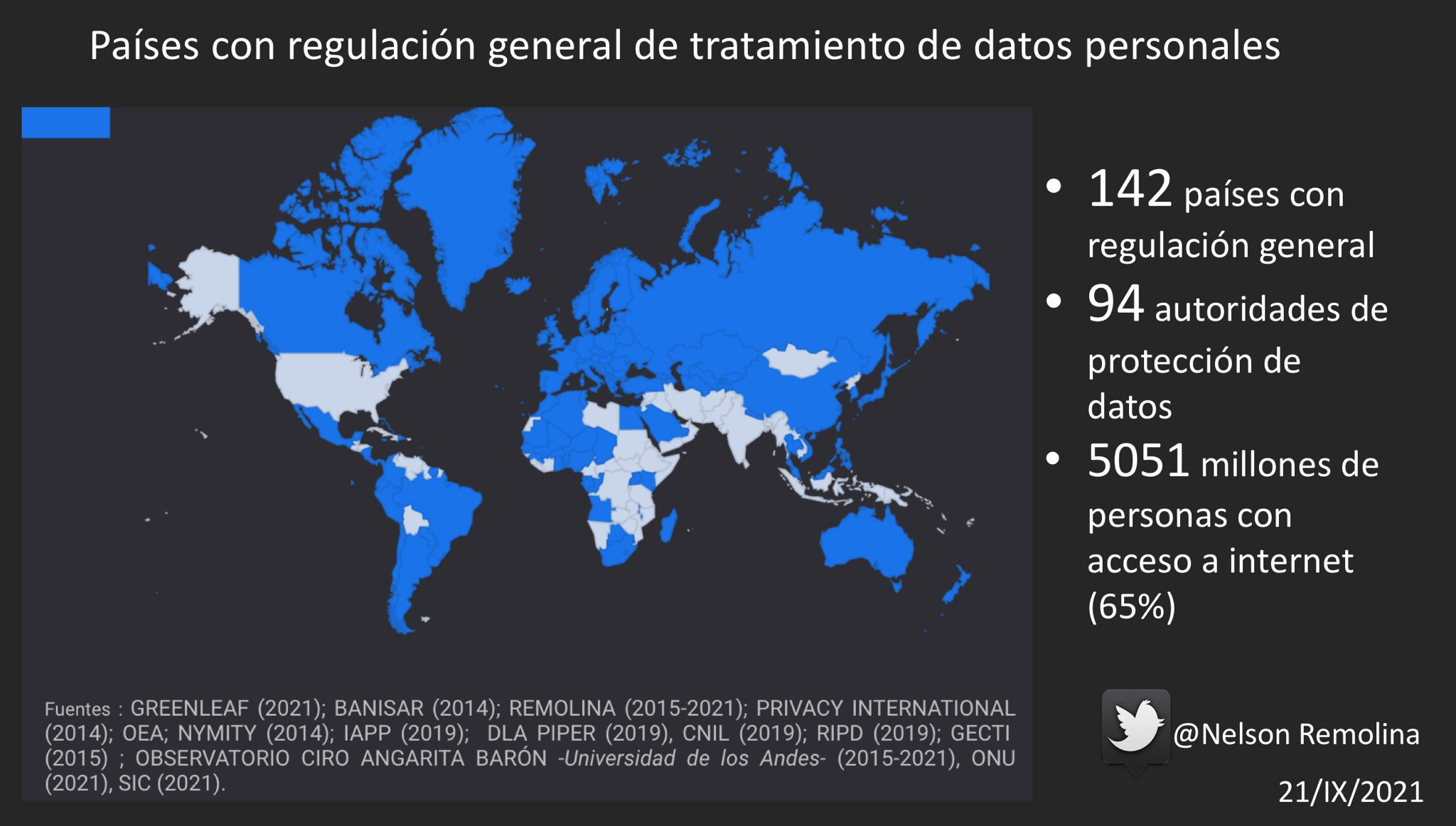

No entanto, hoje em dia o retrato é outro: a proteção de dados pessoais mostra franca evolução, com 142 países tendo algum tipo de regulação de proteção de dados pessoais. O RGPD europeu é uma dessas regulações, e representa uma postura mais severa em relação à proteção de dados pessoais do que as tendências que se via até a sua criação.

Relativamente ao reconhecimento facial, a tendência deste regulamento europeu é limitar a sua utilização para vigilância e controle de locais públicos. Também neste ponto, Michelle Bachelet, Alta Comissária da ONU para os Direitos Humanos, emitiu uma declaração propondo uma moratória sobre a comercialização e uso de sistemas de IA que representem riscos aos direitos humanos até que as salvaguardas necessárias sejam implementadas.

Em desenvolvimentos recentes na região, vale ressaltar que o Uruguai adotou, em 2019, uma estratégia de IA para governança eletrônica; e que a Colômbia está implementando uma estratégia de sandboxes regulatórios para testar implementações de IA pautadas em privacy by design. Esta parece ser uma ferramenta interessante para testar possíveis implementações e derivar insights relevantes.

Uma reflexão final levantada pela Sra. Relatora Especial diz respeito ao significado e à essência da inteligência artificial: “Se a inteligência artificial pretende emular a inteligência humana, e se a empatia e a moralidade são aspectos permeiam a inteligência humana, por que deixaríamos de observá-las ao tratar de inteligência artificial?”.

Farzana Dudhwala

Gerente de Política de Privacidade, Política de IA e Governança, Facebook

A IA apresenta novos desafios para a regulação, que pode tomar diversas formas. É importante que se permita que novas tecnologias se desenvolvam e floresçam. Os sandboxes regulatórios podem ser ferramentas interessantes, pois permitem testagem de iniciativas em cenários controlados. Outra opção é a governança experimental e, em particular, a prototipagem de políticas públicas, que são meios de colaboração multissetorial para compreender os desafios de regulação de uma área.

Enquanto sandboxes são usados geralmente para reformar regulações existentes sob a supervisão de um ente regulatório, a prototipagem de políticas serve para criar novas regulações quando não há nenhuma em vigor. Por isso, a prototipagem é menos formalista e provê maior flexibilidade para pensar meios de regulação que se adaptem à realidade de novas tecnologias.

A prototipagem de políticas tem sido aplicada no projeto Open Loop, que busca criar um loop positivo entre os reguladores e os implementadores dessa regulação. Na América Latina, o projeto tem se focado em transparência de IA, explicabilidade, análise de riscos e equidade. O loop tem fases alfa, de pesquisa e testagem, e fases beta de iteração e ajustes. Concretamente, isto se traduz em quatro passos:

- um consórcio de atores de múltiplas origens e perfis desenvolvem um texto-base sobre um tema, por exemplo a explicabilidade de sistemas de IA;

- este protótipo é testado e aplicado em cenários reais, sob observação para identificar os pontos em que deve ser ajustado para atingir maior eficiência;

- as lições aprendidas são compartilhadas entre todos os atores para que novas iterações regulatórias sejam desenvolvidas; e

- finalmente, as experiências de todos os atores envolvidos são colacionadas em um documento final de recomendação de política pública.

O projeto foi aplicado no México com foco em transparência e explicabilidade ao longo de um período de seis meses. Grande ênfase foi dada à formação de parcerias entre os diversos atores envolvidos, com input de especialistas da região. Atualmente, o relatório final do projeto está sendo finalizado e será publicado em breve.

Karen Duque

Gerente de Assuntos Governamentais e Políticas Públicas do Google

Usos de IA têm grandes potenciais benéficos, mas também envolvem graves riscos. No entanto, IA e privacidade não se anulam, ou ao menos não precisam se anular. Um exemplo interno do Google é o desenvolvimento do Google Assistente.

Todo projeto desenvolvido na empresa é baseado em três princípios: segurança das informações, tratá-las com responsabilidade e sempre pôr o usuário no controle. Isto se traduz, no Google Assistente, em uma série de opções, capacidades e escolhas de design dos assistentes.

Isto inclui o fato de que por padrão o dispositivo não mantém as gravações de áudio; a capacidade de apagar todos os dados com apenas um comando de voz; ajustar prazos automáticos de apagamento dos dados; especificar a sensibilidade do assistente ao comando de voz; e o modo visitante, que veda o acesso a dados pessoais sem impedir o uso do dispositivo. Um último exemplo são os princípios de desenvolvimento de IA no Google, que incluem privacy by design, segurança e accountability.

Veridiana Alimonti

Analista Política Sênior da EFF

Inovação tecnológica e direitos dos usuários devem caminhar lado a lado. A LGPD provê alguns princípios importantes, como a transparência, necessidade e a boa-fé, e é um marco importante de participação social e garantia de direitos. O PL sobre IA deveria almejar ser o mesmo, porém é marcado por debates legislativos apressados e uma abordagem regulatória superficial.

O uso de tecnologias de IA pelos governos deve basear-se na compreensão da proteção de dados como direito fundamental. No Brasil, isto é consequência do recente caso envolvendo o IBGE, decidido pelo STF, mas poderá tornar-se ainda mais concreto com a aprovação da PEC 17/2019. Deste modo, a adoção de tecnologias que possam afetar a proteção de dados deve passar por um teste de balanceamento de direitos.

A LGPD provê uma série de garantias, consubstanciadas nos direitos dos titulares de dados, que serão aplicáveis a implementações de IA. O direito à revisão de decisões automatizadas deve ser visto a partir do ponto de vista do devido processo, de modo que o titular seja capaz não apenas de solicitar a revisão, mas também de compreendê-la. Sobre este ponto, é importante pontuar que mesmo decisões não totalmente automatizadas, mas que contenham algum passo de automatização devem também garantir o acesso a informações que dão base às decisões. Observar os princípios de proteção de dados pessoais, neste sentido, permite um melhor balanceamento das decisões e deverá servir como base para a implementação de políticas públicas relativas a sistemas de IA.

Nina da Hora

Pesquisadora do CTS-FGV, Membra do Conselho de Segurança do TikTok Brasil

A visão técnica e o olhar do usuário devem se sobrepor e conectar. A segurança digital passa necessariamente por compreender como o usuário vai se relacionar com uma nova tecnologia. Assistentes pessoais, por exemplo, têm ajudado pessoas com deficiência de formas imprevisíveis. Desenhar ferramentas de IA significa compreender as habilidades dos usuários de entendê-las e utilizá-las.

A tecnologia continuará sendo cada vez mais presente e inescapável. Pensar a regulação da IA envolve lidar com as tecnologias e não simplesmente afastá-las ou vetá-las. É importante que a sociedade civil se aproxime do processo de regulação para que se criem normas que efetivamente lidem com os desafios da tecnologia. Também é importante uma aproximação entre indústria e academia para prover educação sobre o uso de tecnologias. Crucial, também, é formar pessoas capazes não apenas de construir tecnologia, mas também de pensá-la: encontrar os riscos antes de se tornarem problemas reais.

Sessão 2

Alejandro Pisanty

Membro da Global Partnership for AI da OCDE

O desenvolvimento da tecnologia e da regulação na América Latina é muito desigual. O algoritmo apresenta diversos níveis de viés – alguns comparáveis aos vieses que emergem na própria ação humana, outros mais graves.

A América Latina tem um rico ecossistema de jovens criativos profundamente envolvidos no desenvolvimento de ferramentas tecnológicas, e é preciso estimular o desenvolvimento ético desse ecossistema. O GPAI reúne especialistas de diversas origens em torno do desenvolvimento responsável de IA. Alguns destaques dos projetos desenvolvidos no GPAI são (i) a criação de uma entidade de intermediação de consentimento para o uso de dados para IA; e (ii). a aplicação de IA para a descoberta de novos fármacos. Sobre regulação, é importante reconhecer que existe um discurso refratário à regulação e pautado pela autorregulação e é importante que mecanismos multissetoriais sejam utilizados para estabelecer regulações que não sejam nem severas demais, nem permissivas demais.

Fabrizio Scrollini

Diretor do ILDA

O ILDA buscou compilar o que se sabe sobre políticas e práticas de IA na América Latina. De maneira geral, pode-se afirmar que a região está pouco preparada. Um desafio profundo que enfrentam mesmo os projetos desenvolvidos na América Latina é o uso de bases de dados geradas em outras regiões, referentes a outras populações, o que gera grandes discrepâncias e defeitos na aplicação final de IA. Um caso particularmente relevante é o de uma calculadora de risco de enfermidades crônicas. Com o ajuste dos dados à realidade da população relevante (a mexicana, no caso), aprimorou-se imensamente a eficácia da ferramenta.

Pode-se observar alguns desafios e insights em comum na região. Primeiro, há uma grande variedade de estratégias de IA na América Latina, mas isso frequentemente não se reflete necessariamente nos investimentos necessários e muitas vezes se traduz em documentos pouco específicos, que seriam mais apropriadamente caracterizados como cartas de intenção do que como estratégias – não há estratégias maduras e os investimentos estão muito aquém do que deveriam ser, fora poucas exceções, na América Latina. Segundo, há pouca clareza em relação à governança de dados. Terceiro, há grande desigualdade em relação à implementação das estratégias, com alguns países apresentando focos específicos distintos daqueles definidos nas estratégias. E quarto, que a regulação não representa tanto um empecilho em relação aos dados públicos quanto em relação aos dados privados – neste caso, pode haver reais barreiras de desenvolvimento.

Sacha Alanoca

Pesquisadora Sênior de Políticas Públicas para IA da The Future Society

É interessante analisar o uso de IA para o enfrentamento da pandemia, pois isto revela muitas das oportunidades e desafios dessa tecnologia em relação à proteção de dados, bem como alguns pontos a respeito de políticas públicas de IA. Em análise de mais de 100 ferramentas de IA aplicadas ao enfrentamento da IA, foram identificadas três categorias de aplicações: ao nível molecular (identificação e compreensão do vírus); no campo clínico (aprimorar e acelerar diagnóstico); e no campo societal (infodemiologia, epidemiologia e tomada de decisão informada por evidências).

Algumas dificuldades compartilhadas encontradas foram barreiras éticas e legais (uso de dados sensíveis, principalmente); acesso a dados confiáveis; e adoção e confiança do público. Este último ponto é de especial importância, especialmente em um contexto de crise sanitária. Para promover a confiança, é importante que as decisões sejam tomadas por meio de processos participativos; que sejam desenvolvidos planos de implementação com responsabilidades claras; e que se faça um esforço ativo de identificar os potenciais riscos de aplicações IA.

Arturo Muente-Kunigami

Especialista Sênior do Banco Interamericano do Desenvolvimento

É importante encontrar equilíbrio entre os interesses envolvidos no desenvolvimento da IA. É necessário encontrar espaços de coordenação entre indústria, governo e sociedade civil. Neste esforço, deve estar acima de tudo a intenção de compreender e aprender sobre a IA e os seus riscos, inclusive refletindo sobre as medidas de mitigação possíveis; e a necessidade de conscientizar e informar a população a respeito dos usos dos dados pessoais.

De modo geral, as pessoas compreendem que a proteção de dados é importante, porém não sabem exatamente o porquê. É possível que a ideia de data trusts promova mais controle dos cidadãos, mas isto deve estar aliado a estes esforços de informação e conscientização para que efetivamente tenha efeito. No BID, um destaque é a iniciativa fAIr LAC, focada em promover o uso responsável e ético de dados no desenvolvimento de IA. A ideia é não frear a inovação, mas promover a consciência a respeito dos riscos envolvidos.

Uma outra linha de atenção importante é a criação de regulações específicas a respeito de IA na região. Mesmo aplicações de IA que não envolvam dados pessoais, caso em que as leis de proteção de dados pessoais não se aplicariam, podem ter efeitos críticos sobre as vidas das pessoas, e por isso uma regulação equilibrada é essencial. Um ponto crucial é a aplicação de algoritmos nos processos do setor público, dados o impacto e os riscos envolvidos – o que traz à tona a pergunta sobre se o setor público deveria trabalhar exclusivamente com algoritmos abertos, de modo a promover a transparência.

Constanza Gómez Mont

Fundadora e Presidente do C Minds; AI Chair for Humanity, Chair for World Economic Forum Global Futures Council on AI for Humanity

Como transpor o desafio da confiança em ferramentas de IA? Como implementar a explicabilidade e eliminar vieses? Estas são questões de importância crítica diante de um cenário de crescente digitalização e adoção da IA, mesmo por empresas pequenas. O tema, ao fim, importa em determinar acesso a direitos – serviços, produtos e a realização da igualdade.

Há um grande desafio no sul global, onde apenas um número limitado de pessoas e empresas estão cientes da importância da governança de IA, seu impacto em suas vidas e direitos fundamentais, bem como a compreensão das boas práticas de IA. As pequenas empresas, em particular, muitas vezes dependem do desenvolvimento de terceiros sem uma compreensão de como essas ferramentas são construídas e quais proteções estão em vigor. Compreender a complexidade dos desafios da IA deve ser uma preocupação transversal nestas empresas, não se restringindo às áreas técnicas, e com real envolvimento dos mais altos níveis de gestão.

De modo geral, as empresas europeias já se encontram melhor adaptadas à preocupação com os desafios da IA nas suas aplicações devido a uma relação de longa data com os regulamentos já em vigor. Na América Latina, porém, muitas empresas priorizam outros investimentos e preocupações devido principalmente, como aprendemos em diversos projetos que lideramos, à falta de conscientização sobre o tema, recursos financeiros e recursos humanos.

No entanto, é necessário que tanto os consumidores quanto as empresas tomem consciência de que os desafios da IA em aplicações tecnológicas têm efeitos reais na vida das pessoas e também no desempenho do mercado: em termos de eficiência, já que sistemas de IA bem construídos são mais bem adaptados ao público-alvo e, portanto, são mais eficientes; em termos de ganhos ou perdas de reputação, pois a construção de sistemas éticos de IA pode fazer a diferença entre um e outro; e, com a mesma importância, em termos do impacto na vida de seus stakeholders e comunidades mais amplas, pois a IA pode ter impacto negativo se não for centrada nos direitos humanos e na ética.

Em suma, é necessário criar espaços de discussão aberta e participativa multissetorial para promover mudanças significativas. Alguns pontos particularmente importantes que devem ser tratados são os vieses da IA, seus impactos no meio ambiente e a promoção da transparência e da explicabilidade das aplicações de IA. Iniciativas em andamento na América Latina que abordam essas questões são, por exemplo, o Eon Resilience Lab, o fAIr LAC liderado pelo BID e as recomendações da UNESCO e da OCDE para uma IA ética, entre outros. Além disso, o projeto Open Loop México, o primeiro protótipo de política na região em relação ao teste de mecanismos de governança para transparência e explicabilidade da IA, – liderado por Facebook, C Minds, em colaboração com o Banco Interamericano de Desenvolvimento e com o apoio do Instituto Nacional de Transparência, Acesso à Informação e Proteção de Dados Pessoais (INAI), a participação de empresas e um grupo de especialistas – são projetos experimentais de governança que resultam em lições fundamentais para a regulação neste campo.